De nos jours, la plupart des ordinateurs sont interconnectés entre eux, et rares sont ceux coupés du réseau. On les connecte pour leur permettre d’échanger des informations, qu’il s’agisse de transmettre un courriel ou de télécharger des informations stockées sur les ordinateurs de Wikipédia pour les lire.

On interconnecte aussi les ordinateurs pour leur permettre de collaborer à une tâche trop volumineuse pour être réalisée sur une seule machine. De nos jours, des « fermes » d’ordinateurs regroupent des milliers voire des millions de machines – qui, prises individuellement, ont des performances assez classiques – dans le même hangar climatisé, pour faire toujours plus de calculs à la seconde.

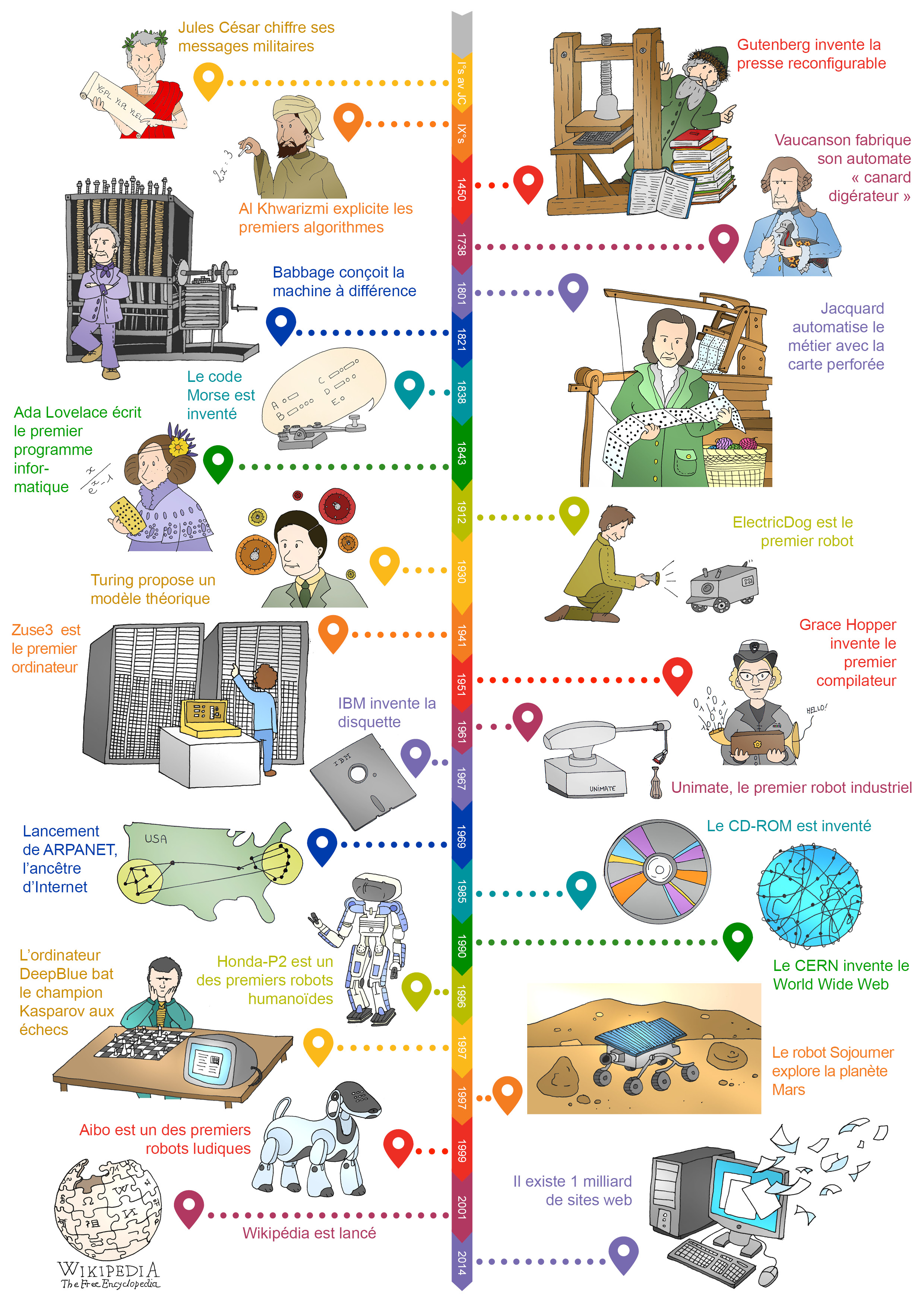

Les premiers réseaux à grande distance sont apparus à la fin des années 1960. On ne comptait qu’une quinzaine de machines interconnectées en 1971, un millier en 1984, un million en 1992, et elles sont plusieurs milliards aujourd’hui. Le premier e-mail date de 1972, le premier site web de 1991, le premier tweet de 2006.

Dans les anciens réseaux téléphoniques, il fallait connecter physiquement deux téléphones de bout en bout pour qu’ils puissent communiquer. Des opérateurs dans des centraux téléphoniques réalisaient ces branchements, qui demandaient d’avoir autant de lignes que de discussions en cours.

La plupart des réseaux informatiques actuels suivent une autre approche plus efficace, nommée commutation de paquets. Les informations sont coupées en paquets, qui sont envoyés les uns derrière les autres. À chaque nœud du réseau (qui est maillé), des routeurs reçoivent ces paquets et les font suivre au suivant, jusqu’au destinataire.

Plusieurs technologies ont été proposées pour échanger ces paquets entre ordinateurs, au risque de faire ressembler les réseaux informatiques à la tour de Babel. Heureusement, Internet permet à tous les ordinateurs qu’il connecte de communiquer malgré leurs différences. Pour parvenir à ce tour de force, les scientifiques et ingénieurs ont appliqué une approche classique en informatique : le problème est découpé en sous-problèmes, qui sont résolus séparément, puis les réponses partielles sont combinées. Ainsi, le problème consistant à échanger des informations entre des ordinateurs est découpé en couches.

C’est ce découpage qui rend possible un réseau à l’échelle mondiale : les technologies sont interchangeables au sein de chaque couche, et l’ensemble collabore grâce à des interfaces standardisées entre les couches. Internet Protocol (IP) est le nom d’un protocole permettant d’interconnecter n’importe quels réseaux locaux entre eux. C’est pour cela qu’on dit qu’Internet est le «réseau des réseaux».

Internet ou Web ?

Dans le langage courant, et très souvent dans les médias, il n’existe pas de différence entre ces deux termes.

Internet est le « réseau des réseaux », et le Web n’est que l’un des réseaux qu’Internet relie (voir ici pour l’historique).

Le World Wide Web, inventé en 1990 au CERN, à Genève, est un réseau de pages liées entre elles exclusivement par liens hypertextes (on reconnaît facilement leur nature car leur URL –Uniform Resource Locator-, leur adresse, commence souvent par « www. ».

Mais il existe d’autres réseaux sur Internet, comme par exemple :

- Les services de courrier électronique (les e-mails), qui utilisent les protocoles SMTP (Simple Mail Transfer Protocol), POP3 (Post Office Protocol version 3), IMAP (Internet Message Access Protocol)…

- Les services de messagerie instantanée (les tchats), sur protocole IRC (Internet Relay Chat), XMPP (Extensible Messaging and Presence Protocol)…

- Les serveurs de forum Usenet (newsgroups), sur protocole NNTP (Network News Transfer Protocol)…

Source : www.fondation-lamap.org